Diseñamos sistemas embebidos capaces de ejecutar modelos de lenguaje (LLM) en local, sin conexión a red, utilizando tecnologías como LLaMA 2, DistilBERT o TinyLLM en plataformas MCU, SoC o FPGA. Integramos aceleradores de IA y optimizamos modelos para ejecutar inferencias de forma segura, rápida y energéticamente eficiente en el edge.

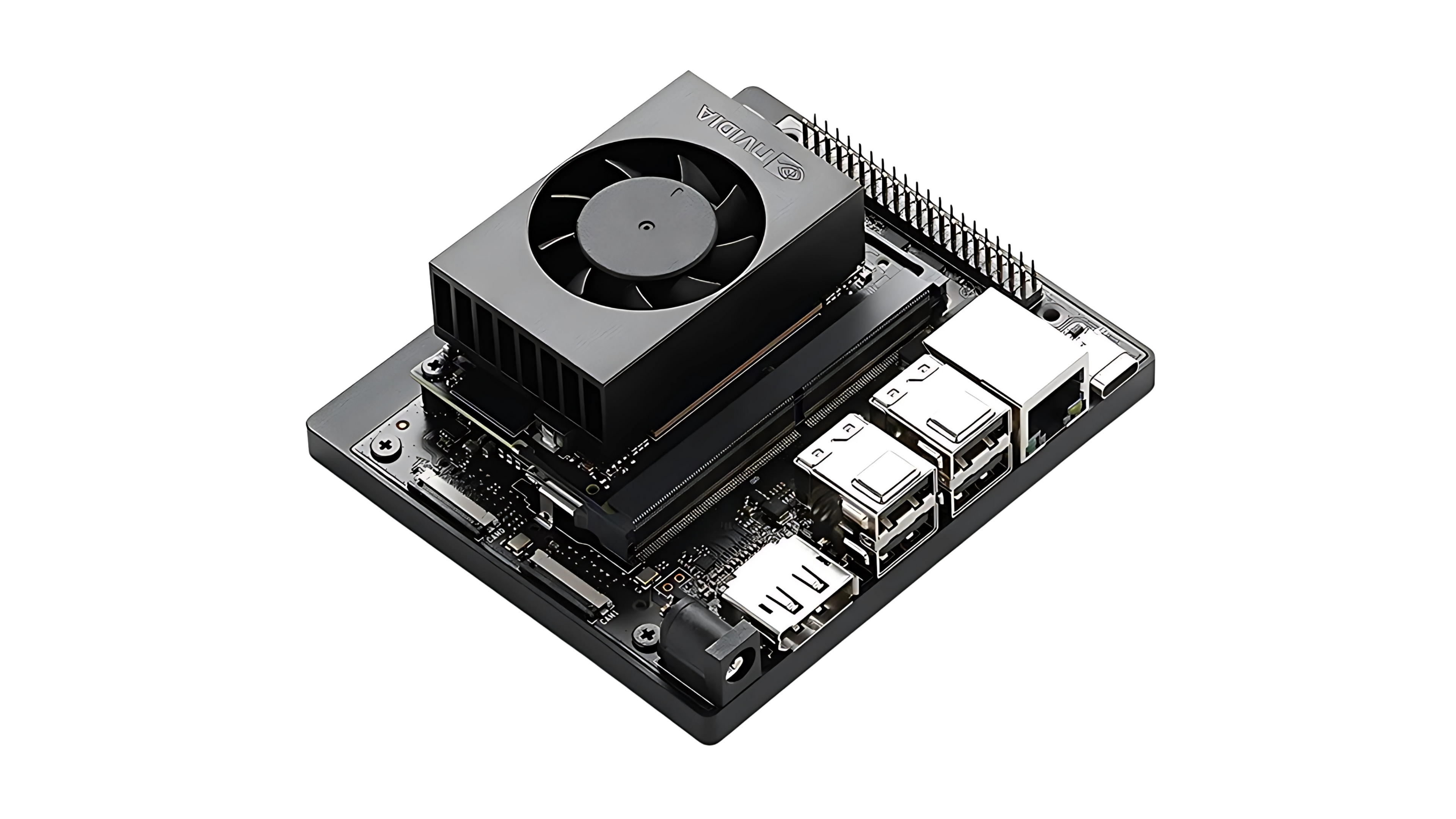

Integración de modelos ligeros como TinyLLM y DistilBERT en placas con Snapdragon y GPU Adreno. Jetson Nano, RK3588, o combinaciones MCU + Coral Edge TPU, Raspberry Pi u Orange Pi. Procesamiento local sin conexión externa.

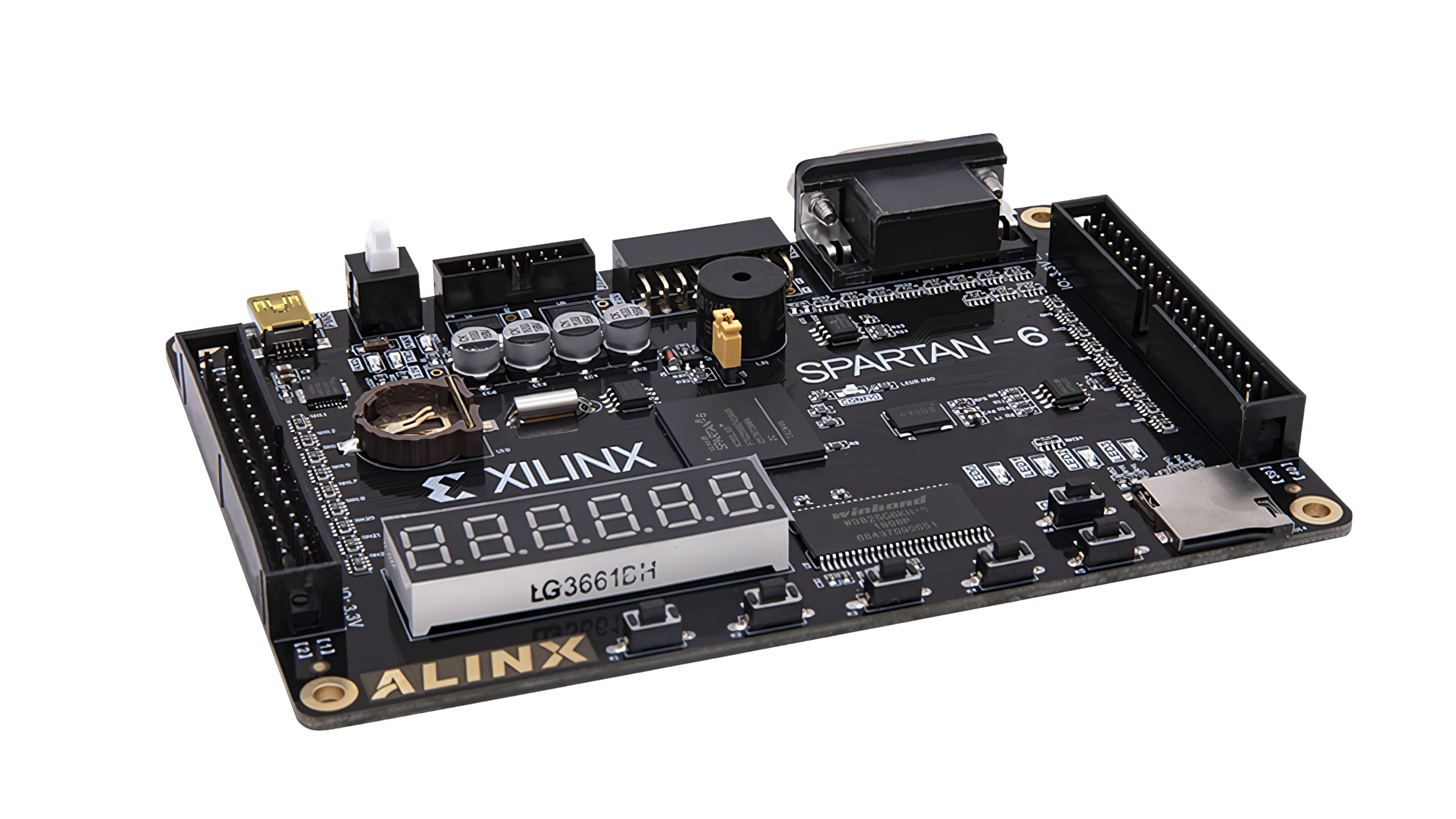

Uso de FPGAs como Xilinx Zynq UltraScale+ o Intel Altera con OpenVINO y Vitis AI para ejecutar modelos optimizados. Soporte parcial para LLaMA y BERT en lógica reconfigurable.

Diseño de sistemas con Coral Edge TPU, Hailo, K210/K510 y microcontroladores para tareas de inferencia rápida, clasificación, resumen, asistentes offline y más.

Dispositivos que responden comandos o generan respuestas localmente, sin enviar datos a la nube. Privacidad total, latencia mínima.

Control de calidad basado en lenguaje, detección de anomalías visuales y respuesta en lenguaje natural integrada con visión artificial.

MCUs que interactúan con sensores, procesan consultas mediante LLM, y controlan dispositivos o máquinas en tiempo real.